Nhà báo Glenn Gabe chia sẻ quá trình xử lý sự cố của mình khi xác định các vấn đề với robots.txt, thứ đã dẫn đến suy giảm dài và từ từ lượng truy cập theo thời gian.

Trước đây tôi đã nhiều lần viết về việc làm thế nào mà các vấn đề SEO có thể dẫn đến lượng giảm đáng kể trong xếp hạng và lưu lượng truy cập. Từ vấn đề thẻ meta robot đến thẻ canonical (nhằm tránh trùng nội dung) đến thủ thuật che dấu 404, một loạt vấn đề như vậy có thể ẩn dấu gây ra thiệt hại nghiêm trọng cho trang của bạn, theo hướng SEO.

Thật không may là tôi mới trải qua tình huống gần đây mà tôi sẽ nói đến trong bài viết này. Vấn đề này đã dẫn đến sự giảm sút từ từ trong xếp hạng và lượng truy cập, điều này rất khó cho các chủ doanh nghiệp có thể nhận thấy. Trước khi doanh nghiệp có thể nhận ra được điều này, những trang quan trọng của họ đã bốc hơi khỏi hệ thống xếp hạng của Google.

Điều gì đã xảy ra? Và sự quan trọng của việc kiểm soát tệp Robots.txt của bạn

Khi nói chuyện với khách hàng về các mối nguy hiểm trong SEO, tôi thường nói đến tệp robots.txt. Nó chỉ là một tệp chữ đơn giản, nhưng nó có thể có tác động nguy hại đến các nỗ lực SEO của bạn nếu không được kiểm soát đúng.

Nó làm tôi nhớ đến khẩu "con dế ồn ã" trong phim Men In Black. Hình dạng thì nhỏ nhưng lại mạnh mẽ kinh khủng.

Mặc dù hầu hết người làm SEO đều hiểu là một dòng disallow (không cho phép) trong robots.txt sẽ gây ra các vấn đề nghiêm trọng, nhưng có nhiều tình huống khác có thể cũng gây ra vấn đề.

Vài vấn đề có thể diễn ra từ từ và làm cho các đường dẫn quan trong biến mất khỏi chỉ mục của Google – và nếu các đường dẫn đó quan trọng, bạn đang đối mặt với một vấn đề lớn. (Và thêm vào đó, bạn sẽ không biết điều này trừ khi ai đó thực sự tìm ra vấn đề đó).

Suy giảm lượng truy cập, mất thứ hạng và đường dẫn không được lập chỉ mục

Một công ty đã tìm đến tôi đợt mùa Thu năm nay, sau khi nhận thấy rằng họ không được xếp hạng với một số từ khóa quan trọng nữa. Họ đã vô cùng lo lắng.

Nhưng với quá nhiều thay đổi của Google, suy giảm trong thứ hạng có thể đến từ bất cứ điều gì, có đúng không? Có thể đó là do cập nhật thuật toán, có thể các đối thủ cạnh tranh đang có thủ thuật gì đó, hoặc có thể, chỉ có thể thôi, có một vấn đề kỹ thuật nào đó gây ra suy giảm thứ hạng. Vì thế tôi đã bắt tay vào tiến hành điều tra.

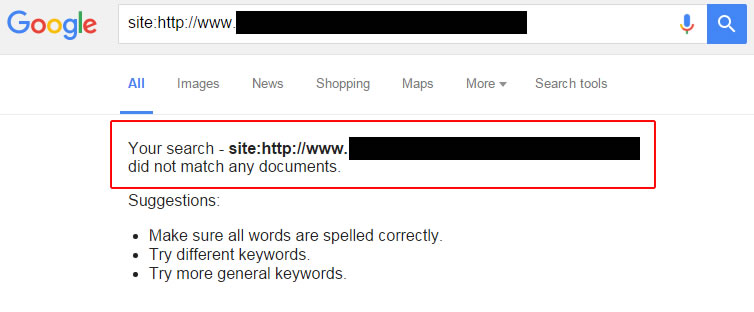

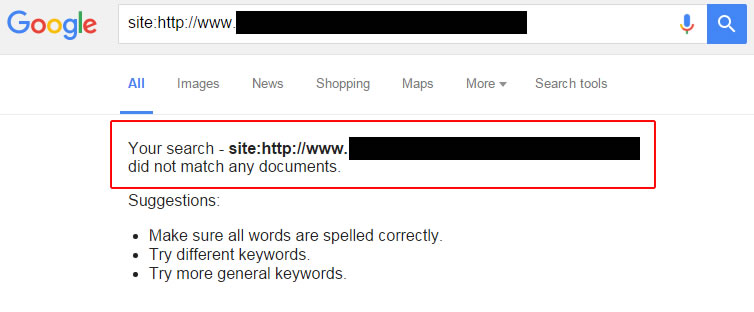

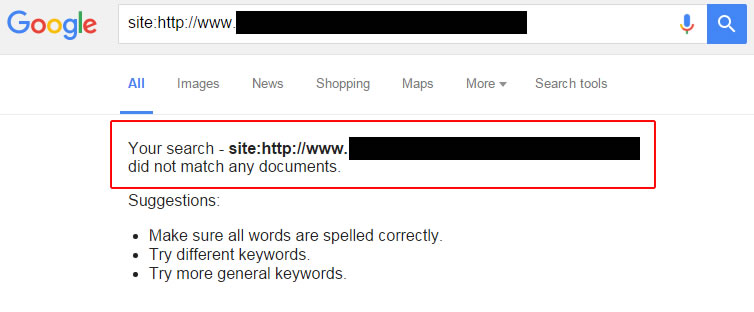

Trong khi nghiên cứu tình huống, tôi đã kiểm tra nhanh các đường dẫn đã từng được xếp hạng cho từ khóa trước đây. Điều thú vị là một số đường dẫn vẫn có thứ hạng tốt, trong khi các đường dẫn khác không thể tìm thấy. Đúng, một số đường dẫn đã biến mất khỏi chỉ mục của Google.

Vì thế tôi đã kiểm tra thẻ meta robots. Không xuất hiện. Tôi kiểm tra các thẻ x-robots để chắc chắn rằng không dòng noindex (chặn lập chỉ mục) không phải là vấn đề. Trường hợp này không phải như vậy.

Sau đó tôi thấy một chuyện. Các đường dẫn tôi kiểm tra đều không có mô tả, phức tạp và sử dụng các kiểu chữ lẫn lộn. Về cơ bản, CMS (hệ thống quản lý nội dung) đã không sử dụng các đường dẫn "đẹp" cho một tỷ lệ lớn các trang của trang web (dựa trên CMS được thiết lập thể nào).

Tôi biết trong các trường hợp thế này, thật dễ để các đường dẫn bị chặn bởi các tệp robots.txt điều khiển tham lam ("Tham lam" đơn giản là chúng có thể chặn nhiều hơn nghĩa vụ của chúng.")

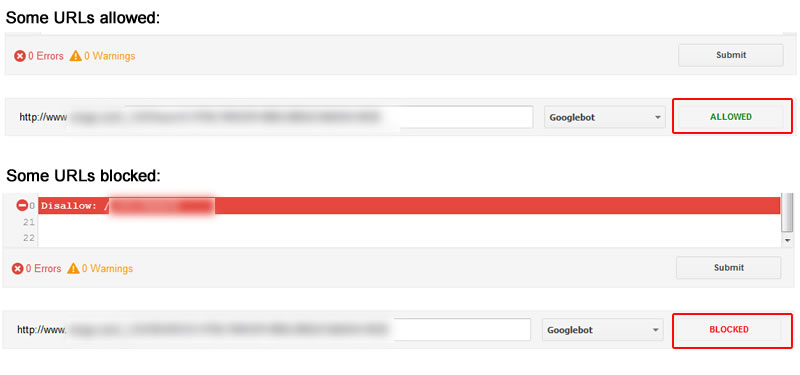

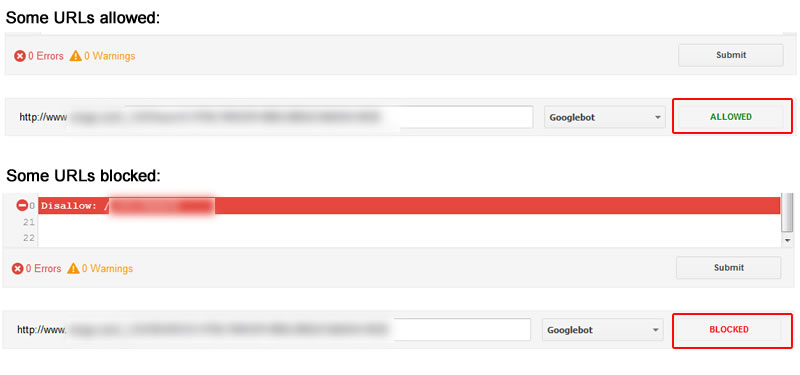

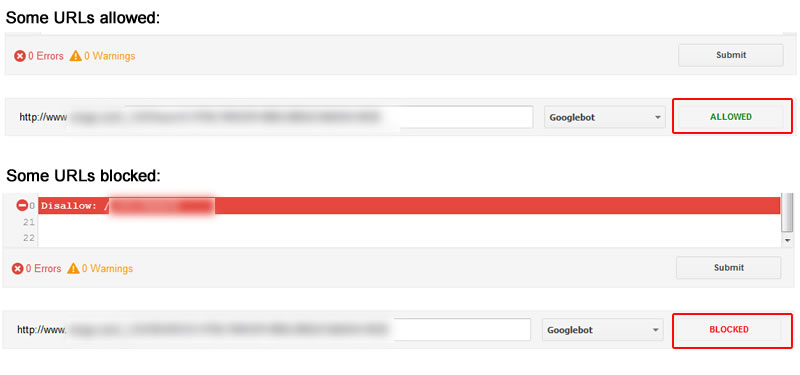

Tôi chạy chương trình robots.txt Tester trong trình điều khiển tìm kiếm Google (GSC) và bắt đầu kiểm tra các đường dẫn. Thật tuyệt khi thấy vài đường dẫn được hiển thị là bị chặn trong khi số khác thì được cho phép.

Tôi cũng trích xuất danh sách các đường dẫn mà trước đây nhận được truy cập tự nhiên từ Google và thu thập chúng. Điều đó giúp tôi có thể xem bất cứ đường dẫn nào mới bị chặn bởi robots.txt (với số lượng lớn). Một lần nữa, kết quả là một số bị chặn và số khác được cho phép. Sau khi phân tích kỹ tình huống, có hai vấn đề được tìm ra.

Phát lộ hai vấn đề quan trọng: Phân biệt kiểu chữ và các thay đổi chỉ thị bên thứ ba

Phân tích tệp robots.txt theo thời gian, tôi thấy hai vấn đề lớn vây ra các rắc rối.

Thứ nhất, các chỉ thị mới được bổ sung và tệp robots.txt bởi nhà cung cấp CMS, và chủ của trang web không biết điều gì đang xảy ra. Trang web này có hàng vạn đường dẫn được lập chỉ mục, vì vậy kể cả một thay đổi nhỏ trong các chỉ thị robots.txt có thể là nguy hiểm.

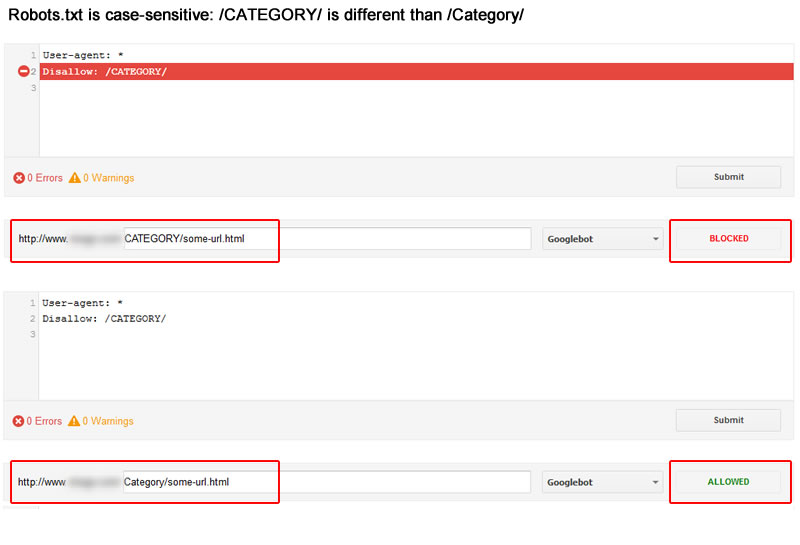

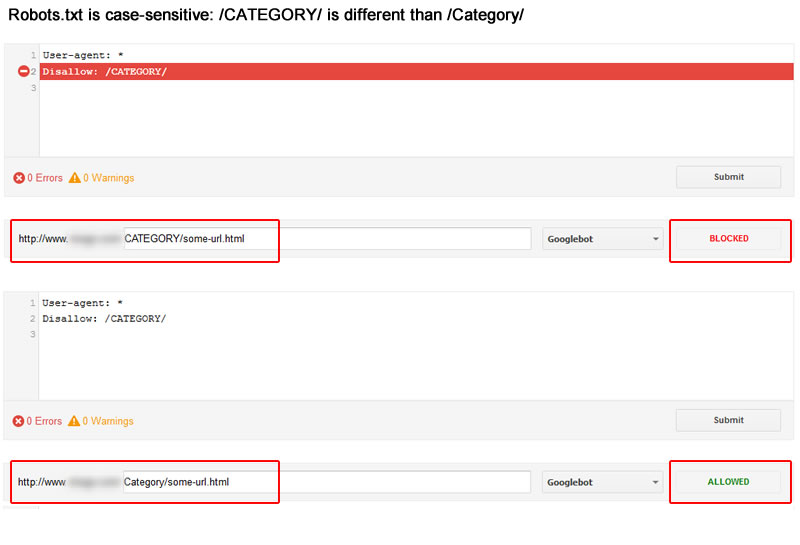

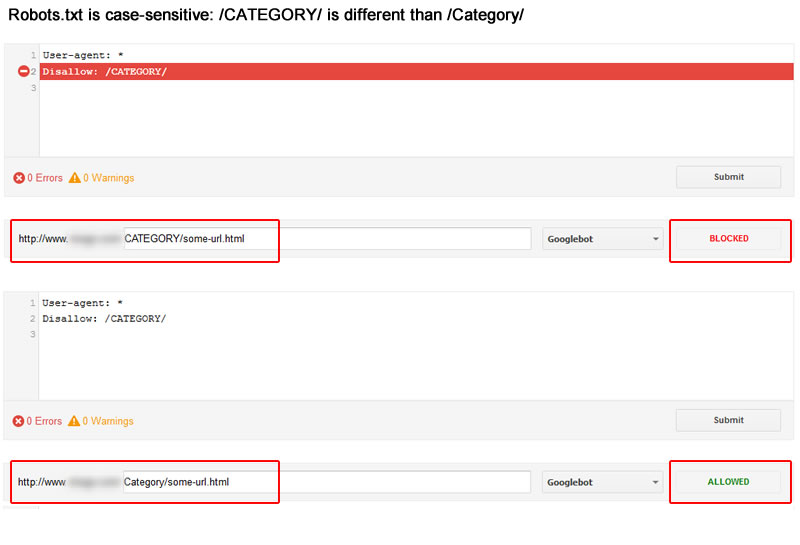

Thứ hai, các chỉ thị đã thay đổi nhỏ trong kiểu chữ. Có nghĩa là các chỉ thị có thể nhận nhầm hoặc bỏ lỡ các đường dẫn của trang.

Lấy ví dụ, khi bạn đang nhắm vào thư mục /Category/ nhưng chỉ thị là /CATEGORY/, thì bạn sẽ không cho phép các đường dẫn trong thư mục /Category/, bởi vì các chỉ thị có phân biệt kiểu chữ. Đó là một lưu ý quan trọng với mọi người làm SEO, quản trị web và chủ doanh nghiệp. Hãy xem hình chụp dưới đây.

Sự nguy hiểm của việc suy giảm từ từ

Với việc các chỉ thị được thêm/bớt theo thời gian và thay đổi phân biệt kiểu chữ, công ty đó có những đường dẫn quan trọng vô tình bị cấm. Khi các đường dẫn bị cấm, Google không thể thu thập các trang để xác định nội dung mà chúng có, và điều này khiến cho các đường dẫn đó suy giảm trong xếp hạng của Google theo thời gian. Điều này là không ổn.

Nhưng đây mới là khó khăn: các đường dẫn thường không suy giảm thứ hạng ngay lập tức – vì thế vấn đề này trở nên rất khó khăn để công ty có thể nhận biết. Nó không phải là một sự suy giảm lớn trong một ngày; thay vào đó họ nhận thấy sự mất mát từ từ các đường dẫn quan trọng khỏi chỉ mục của Google. Như bạn có thể đoán được, xếp hạng và lượng truy cập suy giảm khi các đường dẫn bị đẩy ra khỏi chỉ mục.

John Mueller với vấn đề Robots.txt

Vào tháng Tám năm nay, nhà phân tích xu hướng quản trị web Google – John Mueller ghi lại toàn bộ một buổi hội thảo quản trị web về vấn để robots.txt. Với những người liên quan đến kỹ thuật SEO, đây là một video đáng xem.

Một vấn đề nổi bật là việc John giải thích các đường dẫn bị cấm được xử lý bởi Google như thế nào, theo hướng lập chỉ mục. Ví dụ như các đường dẫn bị cấm sẽ vẫn tồn tại trong chỉ mục, hay sẽ bị loại bỏ, và bao lâu thì chúng sẽ bị loại bỏ?

Ở phút 32:34 trong video, John giải thích rằng Google sẽ loại bỏ các thông tin về các đường dẫn bị cấm từ các lần thu thập trước, và nó có thể lập chỉ mục các đường dẫn chỉ với các thông tin cơ bản.

Thêm vào đó, Google có thể loại bỏ các đường dẫn đó ra khỏi chỉ mục theo thời gian. Không có gì đảm bảo là các đường dẫn sẽ bị loại bỏ, nhưng điều đó chắc chắn xảy ra. Xem video này dưới đây.

https://youtu.be/yIIRyBMSPUk

Vì vậy khi bạn gặp một tình huống khi bạn nhầm lẫn không cho phép các đường dẫn được thu thập, chúng có thể sẽ tồn tại trong chỉ mục một thời gian đến khi Google quyết định loại bỏ chúng. Và khi Google loại bỏ chúng thì bạn sẽ không thấy dấu hiệu nào cho thấy chúng đã biến mất (ngoài việc thấy một lượng giảm truy cập với các đường dẫn đó). Hãy cẩn thận.

Và nếu bạn muốn nghe John nói về việc phân biệt kiểu chữ, bạn có thể xem phút 13:50 trong video. Ông ấy nói một số điểm quan trọng về các chỉ thị, phân biệt kiểu chữ và trùng lặp ký tự.

Làm thế nào để tránh mất mát đường dẫn vì thay đổi của Robots.txt

Làm sao bạn có thể tránh điều này xảy ra với trang web của bạn? Tôi sẽ đưa ra vài gạch đầu dòng dưới đây có thể giúp bạn hiểu khi nào các thay đổi được áp dụng với tệp robots.txt của bạn và làm sao có thể phát hiện ra các đường dẫn trước đây thu hút truy cập đang bị cấm bởi robots.txt.

Đây không phải là một danh sách khuyến nghị cuối cùng hoàn chỉnh, tuy nhiên các gạch đầu dòng dưới đây chắc chắn có thể giúp bạn tránh các tai họa SEO vì các vấn đề của robots.txt.

• Thường xuyên thu thập thông tin và kiểm tra trang của bạn. Tôi nói nhiều về điều này gần đây. Bạn càng thu thập nhiều về trang của mình, bạn càng hiểu được điểm mạnh, điểm yếu và các nguy cơ của nó. Và như một phần của việc thu thập, bạn có thể xem các đường dẫn bị cấm bằng một số các công cụ (bao gồm Screaming Frog, DeepCrawl và các công cụ thu thập khác). Bạn có thể thấy các đường dẫn quan trọng bị chặn. Nếu vậy hãy phân tích cặn kẽ vấn đề.

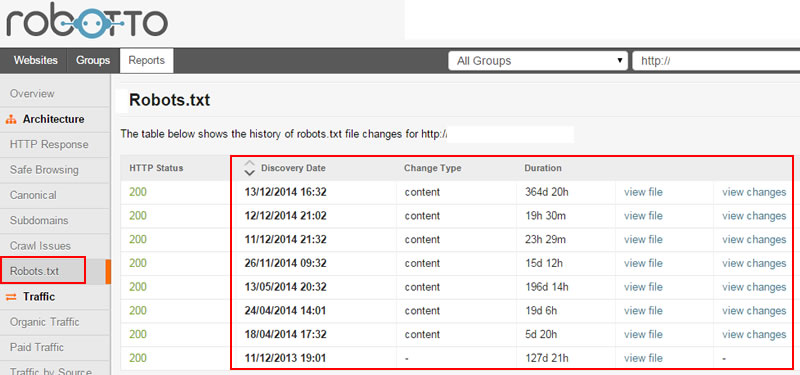

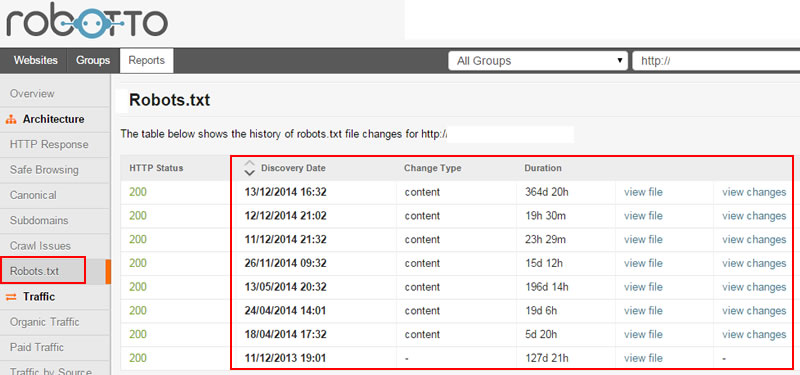

• Lịch sử thay đổi của Robots.txt. Bạn có thể yêu cầu có các thông báo từ nhà cung cấp CMS của mình bất cứ khi nào có thay đổi được tiến hành với tệp robots.txt của mình. Nếu họ có thể email hoặc nhắn tin cho bạn về các thay đổi này, bạn có thể nhanh chóng kiểm tra chúng. Và bạn có thể nhanh chóng giải quyết các vấn đề.

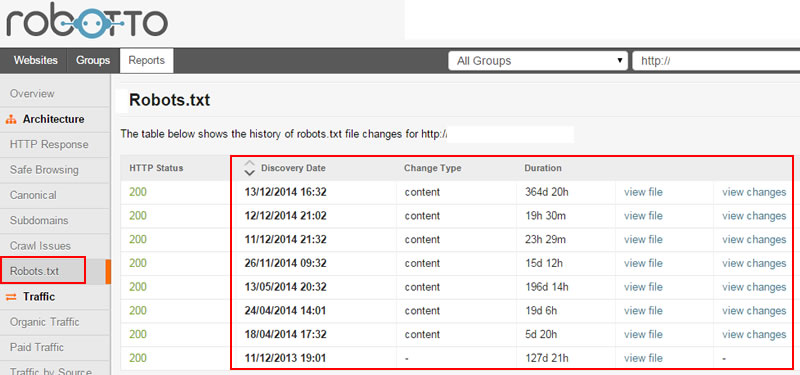

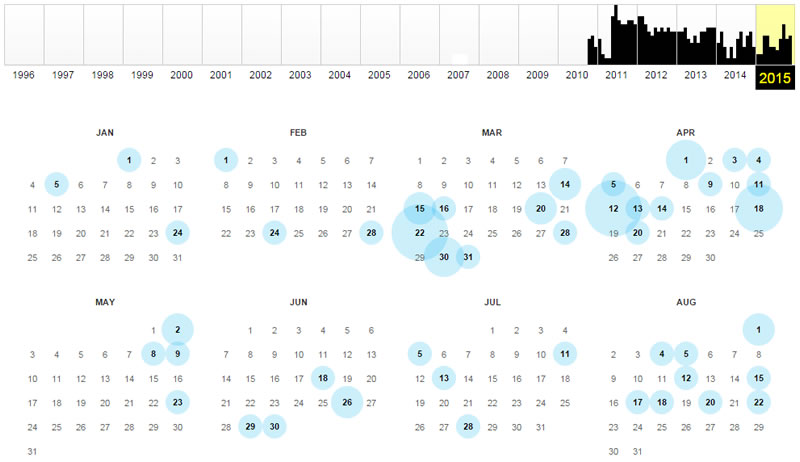

• Tự động phát hiện thay đổi của robots.txt. Bạn có thể sử dụng một dịch vụ kiểm tra tệp robots.txt của mình hàng ngày. Bất cứ khi nào thấy một thay đổi, nó sẽ thông báo với bạn. Sau đó bạn có thể kiểm tra và tiến hành các thay đổi khi cần thiết. Nó giống như dịch vụ Google Alert với kỹ thuật SEO. Ví dụ như Robotto có thể phát hiện một số thay đổi quan trọng và thông báo đến bạn.

• Liên tục kiểm tra trình điều khiển tìm kiếm Google (GSC). Bạn nên thường xuyên kiểm tra các báo cáo của GSC. Có vài báo cáo có thể giúp bạn xác định các vấn đề với trang của bạn từ góc nhìn của một kỹ thuật SEO. Với tình huống này, sử dụng công tụ robots.txt Tester với các đường dẫn quan trọng sẽ có ích. Bạn cũng có thể kiểm tra trạng thái chỉ mục (Index Status) với cụm "blocked by robots", điều này có thể cho bạn thấy một lượng tăng trong con số các đường dẫn bị chặn bởi robots.txt (đây có thể là báo động đỏ). Và sau đó bạn có thể kiểm tra Smartphone Crawl Errors với "Blocked". Có thể tìm thấy điều này trong thẻ Smartphone nhưng nó cũng có thể liên quan đến các đường dẫn với máy bàn.

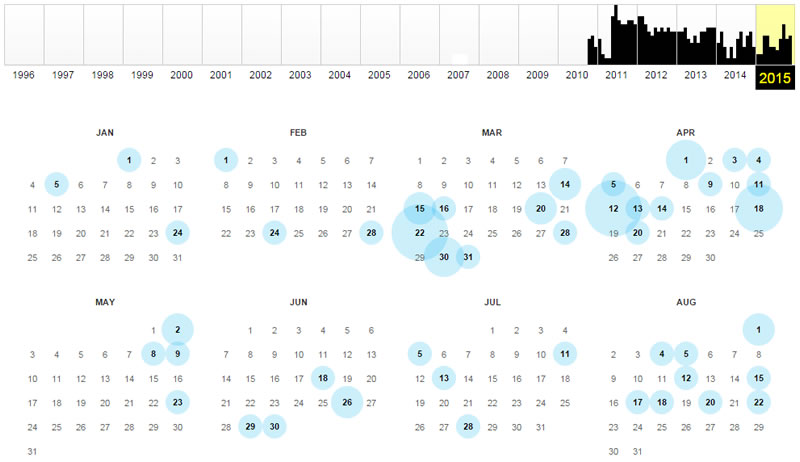

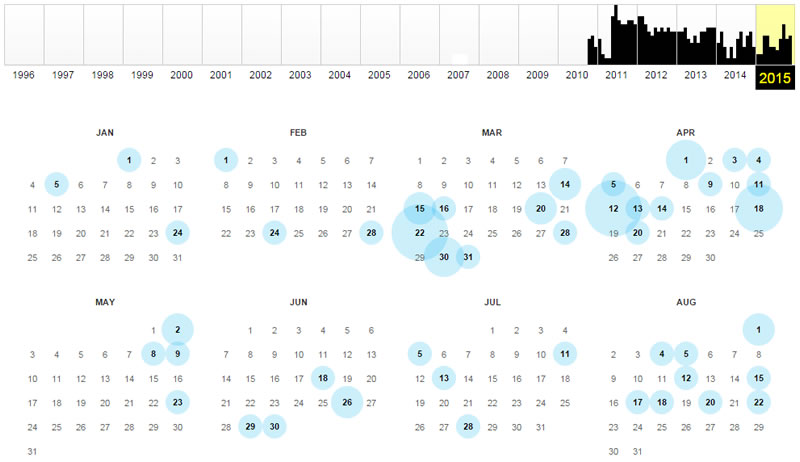

• Sử dụng Wayback Machine để kiểm tra robots.txt. Đúng, bạn có thể công cụ thewaybackmachine để kiểm tra tệp robots.txt theo thời gian. Với nhiều trang bạn sẽ thấy nhiều phiên bản của robots.txt được ghi lại theo vòng đời của trang web. Nó có thể cho thấy các đầu mối quan trọng về sự sụt giảm trong xếp hạng trang.

Kết luận: Kiểm tra "Bên Trong", theo hướng SEO

Như bạn có thể thấy với trường hợp này, các thay đổi của kỹ thuật SEO có thể có ảnh hưởng lớn đến xếp hạng và lượng truy cập. Mặc dù robots.txt chỉ là một tệp chữ đơn giản, các chỉ thị mà nó có có thể chặn các đường dẫn quan trọng được thu thập (điều này có thể dẫn tới việc các đường dẫn đó bị loại bỏ khỏi chỉ mục Google).

Và nếu các trang web đó bị loại bỏ khỏi chỉ mục, chúng sẽ không có cơ hội được xếp hạng. Và với việc không có cơ hội xếp hạng, chúng không thể thu hút truy cập. Có nghĩa là bạn sẽ nắm phần thua trong khi các tệp robots.txt thắng. Đừng để nó thắng bạn. Hãy làm theo các chỉ dẫn của tôi ở trên để tránh mất mát các đường dẫn.

Nguồn:http://searchengineland.com/